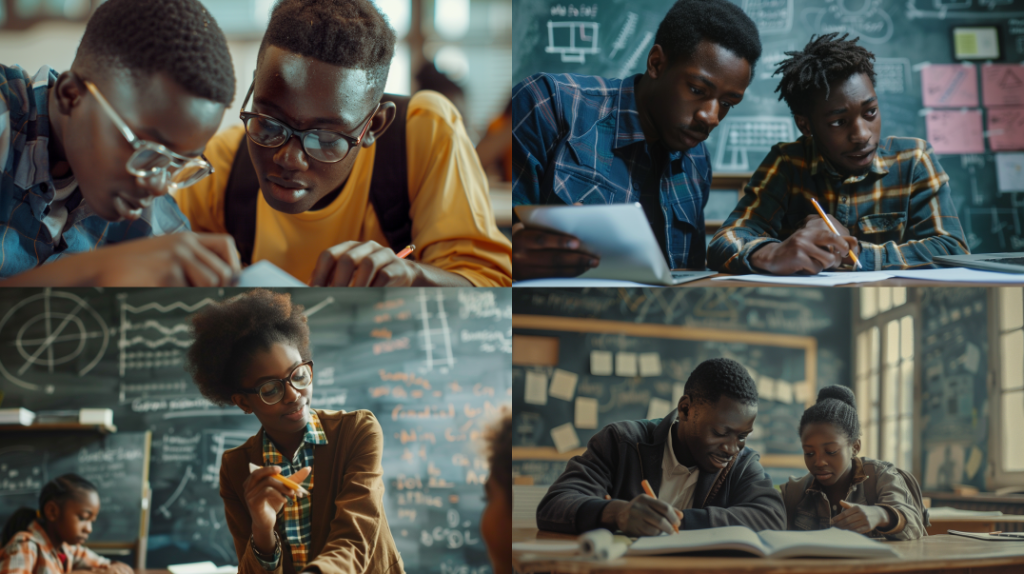

Ich habe heute den für mich sehr hilfreichen Blogbeitrag von Per Axbom über Bias in KI gelesen. Er referenziert darin auf eine Studie, in der Nutzer*innen daran scheiterten, sich mithilfe eines Bildgenerierungs-Tools ein Bild von einem afrikanischen, schwarzen Arzt generieren zu lassen, der ein weißes, krankes Kind behandelt. Entweder war der Arzt weiß und das Kind schwarz. Oder das Kind war zwar weiß, aber wurde dann nicht mehr kindlich und behandlungsbedürftig, sondern im Arztkittel dargestellt …

In diesem Blogbeitrag stelle ich zwei Bildgenerierungs-Experimente vor, die ich daraufhin unternommen habe und teile meine Schlussfolgerungen dazu.

Worum geht es?

KI-generierte Inhalte sind zwangsläufig immer Bias-behaftet, denn KI-Tools reproduzieren die Vergangenheit. Stereotype, Diskriminierungen und Vorurteile, die es in den letzten Jahrzehnten in unserer Gesellschaft gab und weiterhin gibt, finden sich vor diesem Hintergrund in den Trainingsdaten und damit auch im Output der vorherrschenden KI-Tools wieder.

Meine bisherige Lösung zum Umgang mit dieser Herausforderung war ein bewusstes und gezieltes Prompting. Das bedeutet: Wenn ‚von allein‘ keine Diversität generiert wird, dann muss ich in meinen Prompts eben gezielt Diversität einfordern.

Mithilfe meiner Experimente habe ich nun gelernt: Das reicht an vielen Stellen nicht aus!

Wie sahen meine Experimente aus?

Ich habe das Bildgenerierungstool Midjourney genutzt und zunächst mit dem Prompt experimentiert: „Eine Person hält einen Vortrag auf einer Konferenz.“

Wenig überraschend erhielt ich ausschließlich Bilder von weißen Männern, die reden.

Besseres Prompting würde nun bedeuten, dass ich mir dieses Stereotyps, dass es überwiegend weiße Männer sind, die redend auf der Bühne dargestellt werden, bewusst bin und dann ganz gezielt ‚dagegen‘ prompte. Ich änderte deshalb also meinen Prompt in: „Eine schwarze Person hält einen Vortrag auf einer Konferenz.“

Tatsächlich ist nun die redende Person schwarz. Zugleich besteht damit aber nun auch das Publikum aus (überwiegend) schwarzen Personen. Das war eigentlich nicht meine Intention.

Noch schwieriger wird es, wenn ich nach einer Person im Rollstuhl frage, die einen Vortrag auf einer Konferenz hält. Denn wirklich redend/ erklärend ist die porträtierte Rollstuhlperson nicht, sondern eher zuhörend. Und daneben gibt es nun auch oft ganz viele Rollifahrer*innen im Publikum.

Mein zweites Experiment war der Prompt, dass eine Person einer anderen Person Mathematik beibringt. Da ich hier zwei verschiedene Personen im Prompt hatte, konnte ich beiden Personen bestimmte Merkmale zuweisen.

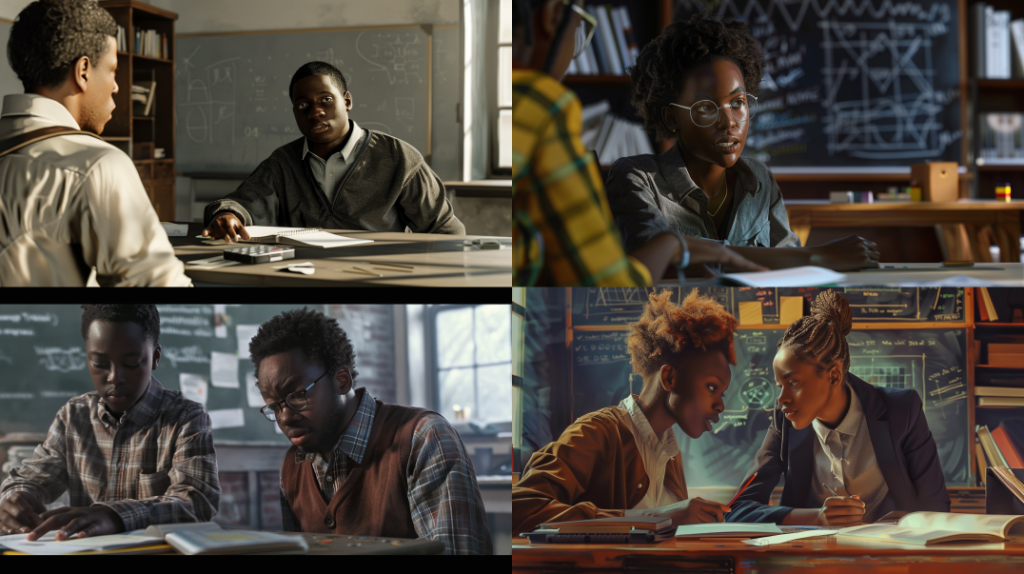

Wenn ich die beiden Personen nicht näher bestimme, erhalte ich diese Ausgabe (= mein neutraler Prompt wird übersetzt in: Männer bringen Frauen oder Kindern Mathematik bei):

Wenn ich auch hier wieder versuche, mehr Diversität reinzubringen, indem ich zunächst nur die Merkmale der lehrenden Person verändere, dann passiert das gleiche wie oben beim Konferenzpublikum:. Auch die lernende Person erhält – ohne dass ich das im Prompt explizit einfordere – das gleiche Merkmal, wie die lehrende Person (und es werden zum Teil sehr merkwürdige Rollstühle generiert).

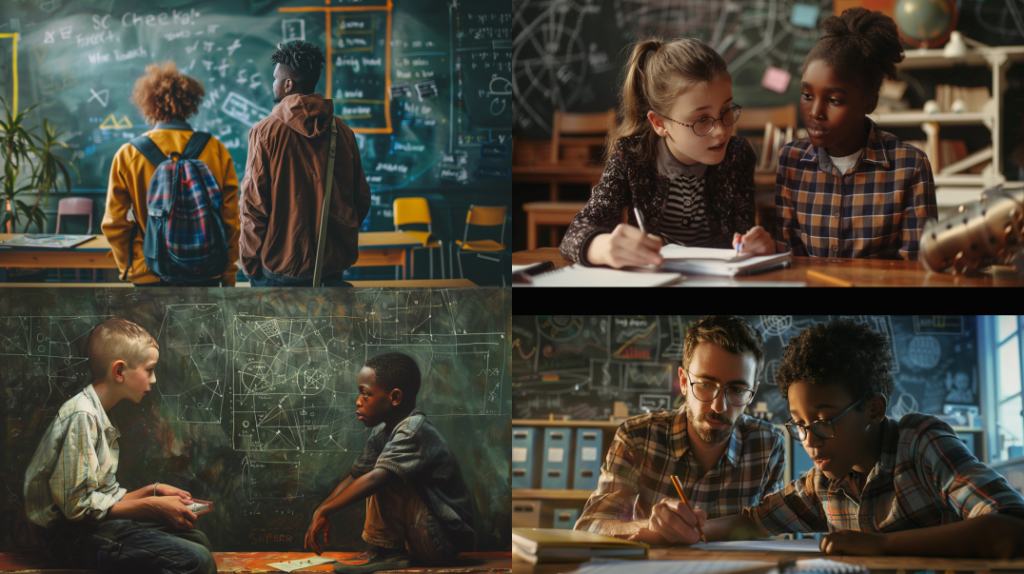

Richtig spannend wird es dann, wenn ich die zweite Person explizit anders prompte, also wenn ich eine Person im Rollstuhl möchte, die einer Person, die nicht im Rollstuhl ist, Mathe beibringt. Oder eben eine schwarze Person, die einer weißen Person, Matheaufgaben erklärt. Die Ergebnisse sind kaum von der obigen nicht-definierten Version der zweiten Person zu unterscheiden.

Während ich das bei der Person im Rollstuhl noch bis zu einem gewissen Grad nachvollziehen kann, denn der Begriff Rollstuhl – egal ob mit oder ohne davor – führt zur Darstellung einer Person im Rollstuhl, so ist das bei der schwarzen und weißen Person nicht nachvollziehbar. Vor allem da der umgedrehte Prompt (= eine weiße Person bringt einer schwarzen Person Mathematik bei) deutlich besser klappt.

Ist das wirklich immer so?

Ich habe in diesem Blogbeitrag jeweils die Bilder verwendet, die mir bei der Generierung als erstes angezeigt wurden. Natürlich muss sich das nicht immer genau so reproduzieren lassen, aber die Tendenz scheint schon sehr eindeutig zu sein. Ich habe noch ein paar mehr Bilder generiert. Manches Mal ist es dann doch besser, als oben beschrieben, aber das hilft ja insgesamt nichts. Grundsätzlich lässt sich festhalten, dass Konstellationen in denen eine Person mit einem Diversitätsmerkmal, das in unserer Gesellschaft zu Diskriminierung führt, deutlich schwerer in einer handelnden / redenden / erklärenden Positionen gegenüber Personen ohne solch ein Diversitätsmerkmal dargestellt werden kann, als anders herum.

Mir ist durchaus klar, dass ich es, wenn ich es darauf angelegt hätte, sicherlich Bilder hinbekommen hätte, wo die gewünschte Darstellung doch geklappt hätte. Es ist aber kaum zu erwarten, dass dieser Aufwand von Nutzer*innen tatsächlich realistisch betrieben wird.

Was lerne ich daraus?

Ich nehme aus diesen Experimenten mit, dass besseres, weil bewusstes Prompting nicht immer die Lösung gegen Bias ist. Das Problem des Bias gründet sich in den Trainingsdaten und darin, dass Output gemäß der größten Wahrscheinlichkeit generiert wird. Wenn es für bestimmte Konzepte (z.B. ein schwarzer Mensch erklärt weißen Menschen die Welt – und eben nicht anders herum) kein oder nur sehr, sehr wenig Bildmaterial gibt, dann hilft auch besseres Prompting nicht. KI-Tools können uns, auch wenn wir das von ihnen einfordern, nicht Bilder einer besseren Welt generieren, als die, die wir in den Trainingsdaten zur Verfügung stellen.

Für Bildungsangebote zu KI bedeutet das aus meiner Sicht, …

- dass wir noch mehr erklären müssen, wie KI-Tools funktionieren

- dass wir lernen müssen, generierten Output kritisch zu reflektieren (gerade auch an Stellen, wo es weniger offensichtlich ist, als in meinen Beispielen)

- und dass es wichtig ist, Transparenz über Trainingsinhalte, Filtermechanismen und Gestaltung der Tools einzufordern.

Bei alledem sollten wir aber vor allem die wichtigste Schlussfolgerung nicht aus dem Blick verlieren:

Das Hinwirken auf eine Gesellschaft, in der sich alle gleichberechtigt beteiligen können und niemand diskriminiert wird, muss viel mehr noch als bisher ein grundlegendes Bildungsziel sein. Mit den von uns Menschen gestalteten KI-Tools halten wir uns selbst ein bisschen einen Spiegel vor und können sie als Reflexions- und Analyseinstrument nutzen.

Beitrag merken & teilen

Hier kannst Du dir den Link zum Beitrag kopieren - beispielsweise um ihn für Dich zu speichern oder mit anderen zu teilen. Wenn Du den Link in den Suchschlitz im Fediverse einfügst, kannst Du den Beitrag von dort aus kommentieren. Die Kommentare erscheinen dann nach Freigabe hier auf der Website.

Beitrag weiternutzen

Der Beitrag steht unter der Lizenz CC BY 4.0. Du kannst ihn gerne unter Angabe des Lizenzhinweises offen weiternutzen.